開発環境まわりの内容となり。先人様の情報を元に調査しました。

google colab(google colaboratory) を試してみました。機械学習系の

いくつかのライブラリがインストール済みで、

クラウド上で、ある程度機械学習の開発ができそうです。

*) 連続 使用時間は、12時間までらしいです。

# thanks, 感謝です。

https://qiita.com/tomo_makes/items/f70fe48c428d3a61e131

http://uepon.hatenadiary.com/entry/2018/03/21/180329

# 操作方法など、

colab を chrome ブラウザで開きます。

https://colab.research.google.com

jupyter-notebook に、操作方法は似ているイメージでした。

コードセル内で

! を先頭に追加すると、unixコマンドが使用できました。

!ls

> datalab

みたいな、操作です。

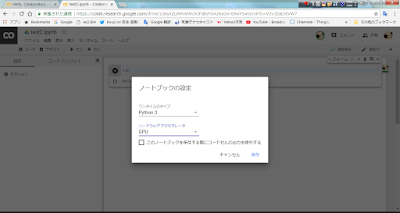

ランタイム - ランタイムのタイプの変更

でノートブックの設定が開き、

ハードウエアアクセラレータを、GPUに変更できました。

*)処理内容によりますが、学習データ件数が少ない場合等で、

CPU処理のほうが、高速の場合もありました。

# pip 関連

tensorflow

Keras

matplotlib

numpy

pandas

scikit-learn

など、使えそうな物は複数ありそうです。

# ファイルの転送は、上記のueponさんの

記事を参考にして、csvファイルを転送しておき。

csv読み込み +kerasのRNN系 結果の matplotlibグラフ表示まで

実行できました。

*)今回は1ファイル毎の転送で。面倒でした。。

# まとめ

カンタンな紹介程度の内容すが。

クラウド上で無料で利用できて、ある程度の機械学習の機能

が使えるため、python 系のインストールの負担も減り良さそうですが

落とし穴あるかもですね。。

# 関連のまとめ

機械学習 関連まとめ

http://knaka0209.blogspot.jp/2018/01/tensorflow-matome.html

### update : 2018/03/23 ###

colab のipynb ファイルから、外部ファイルの読み込み方法(追記)

colab ノートブックから、外部データファイル(csv etc)や、外部python クラスを呼ぶ場合、

前回、[ from google.colab import files ]を使った、アップローダでファイル転送しました。

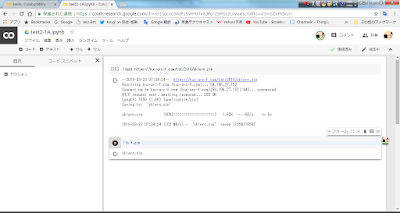

今回は、異なるファイル転送で

ノートブックから、unixコマンドが使えるので。wget, git clone(gitHubから)を

使って、関連プロジェクトの複数ファイルを一括コピーしてみました。

*) 単純に外部サイトから、複数ファイルコピーできて利用できたので紹介です。

# wget

wget https://your-dns/sklern.zip

# unzip します

!unzip sklern.zip

# カレントフォルダにmv 又は, cp (解凍したフォルダ以下)

!mv sklern/* .

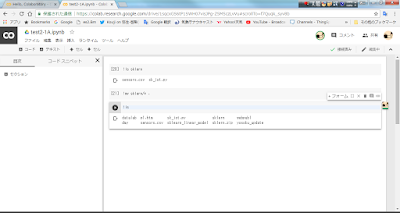

# 実行

コマンドセルに、呼び出しコード(main処理)を貼り付けて、実行

*) この場合csvファイルのみですが、自作外部pythonクラスも同様に読めました。

実行2、グラフ表示。

## git clone した場合も同様に、フォルダ以下を mv(cp)して、読み出すことができました。

*) 事前にgithubに、プロジェクト全体をコミット後です(公開前程の場合ですが。)

cloneの例:

git clone https://github.com/your-name/app123.git

## ポイントは、少しわかりずらいですが。

1) wget , git clone で外部ファイルをzip形式等でコピーできる事

2) コピーしたファイル(フォルダ)を一括解凍などでカレント配置し、

ノートブックのipynb ファイルから、読める事

*) 作業フォルダはipynb ファイル以外は、定期的に削除されていたかもですので。

利用時に一括コピーする必要があるかもです。

0 件のコメント:

コメントを投稿